生成AIの開発現場活用術

はじめに

前記事(生成AIのビジネス活用(初心者向け))でも紹介した通り、生成AIは日々進化を続けています。

開発現場の観点で見ると「コードを書く道具」から、「開発の進め方そのものを変える道具」へと変化しています。

とはいえ、現場によって受け入れられ方は大きく異なります。

生成AIを積極的に使ってスピードを上げる現場もあれば、セキュリティ要件が厳しい、顧客データを扱っている、社内ルールで制限されているなどの理由のため、利用が厳格に制限される現場も多いのではないでしょうか。

本記事では、生成AI活用が寛容な現場と厳格な現場、それぞれの視点から“生成AIの開発現場活用”を整理します。

本記事でいう「寛容/厳格」は、

(1)投入できるデータの範囲

(2)外部サービス利用の可否

(3)監査・証跡の必要度

で便宜的に分けています。

例えば「個人情報や顧客ログを扱う」「規制業界で監査が厳しい」「持ち出し禁止ネットワーク」などが重なるほど厳格寄りになります。

まず開発現場のデータ区分と持ち出しルールを確認し、どのレベルの制約が必要かを決めるのが第一歩です。

生成AIの活用が寛容な現場

生成AIの利用に寛容な現場では、ポイントは「小さく試して効果を見える化すること」です。

例えば、GitHub CopilotやChatGPT、Cursorのようなツールを導入すると、コード補完やテスト生成、リファクタリング支援により、生産性が上がりやすいです。

しかし、成果が出るチームと出ないチームの差は“使いどころ”の設計にあります。

まずおすすめなのは、作業の分解です。

生成AIは「要件を理解して一気に完成」よりも、「小さなタスクを高速に回す」方が得意な傾向があります。

たとえば、

①関数の役割を明確化

②例外ケースの洗い出し

③ユニットテストの追加

④リファクタ

というように工程を区切ると、出力の品質が安定します。

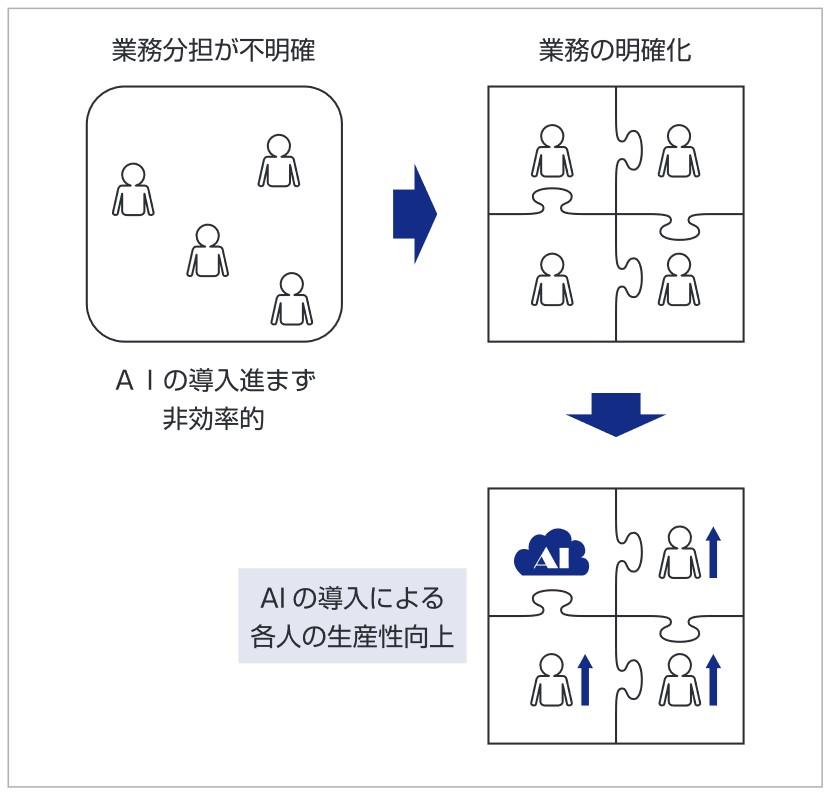

次に重要なのは、レビューと責任の線引きです。

AIが書いたコードは、見た目が正しくても仕様の取り違いやセキュリティ上の穴を含むことがあります。

そこで、AIは“下書き担当”、人間は“設計判断とレビュー担当”という役割分担を明確にします。

具体的には、プルリクエストテンプレートに「AI利用の有無」「人間が確認した観点(例:例外処理、入力値検証、権限)」を入れるだけでも品質が上がります。

さらに、寛容な現場だからこそ注意すべきは情報の取り扱いです。

便利だからといって社外秘のログや顧客情報をそのまま貼り付けるのは危険です。

最低限、個人情報・顧客名・IP・ドメインなどはマスキングし、必要なら利用ルールを設けます。

下記の例のように置換ルールを決めておくと運用が楽になります。

・IPアドレス

10.x.x.x ⇒ 10.***.***.***

・ユーザーID

xxxxxx ⇒ ハッシュ化「早く使える」現場ほど、早めに安全対策を練ることが長期的な成功につながります。

生成AIの活用が厳格な現場

一方、金融・官公庁・大規模SIなど、生成AIの利用が厳格な現場では「使う/使わない」ではなく、どう統制しながら使うかが焦点になります。

多くの場合、個人が勝手に外部AIへデータを投げることは禁止で、監査や証跡、データ持ち出し防止が求められます。

このタイプの現場で強いのは、Azure OpenAI ServiceやAmazon Bedrockのように、企業向けの管理機能を備えた基盤を利用するアプローチです。

厳格な現場で企業向け基盤が選ばれやすい理由は、モデル性能というより運用要件です。

例えば、利用者の認証(誰が使ったか)、ログ保存(監査で追えるか)、ネットワーク制御(ネットワーク分離やアクセス制御を設計しやすい)、鍵管理、利用制限(部署・時間帯・回数)など、“止める仕組み”を最初から作りやすく、結果として「使う/禁止」ではなく「条件付きで使う」を実現できます。

加えて、社内文書を検索して回答するRAG(Retrieval Augmented Generation)構成を使えば、外部に情報を出さずに「社内の知識を活用するAI」を作れます。

RAGはざっくり言うと、

①社内文書を検索できる形に整える(分割・索引化)

②質問に応じて関連資料を引っ張る(検索)

③その資料だけを根拠に回答を生成する(生成)

の3段構えです。

また、ローカル環境(社内閉域)に生成AIの実行環境を構築して運用する選択肢もあります。

ただし、「ローカルだから安全」で終わらせず、投入データの範囲/利用者の権限/出力の検証に加えて、外部通信の制御やログの扱い、モデル・ライブラリの更新手順(脆弱性対応)まで含めて統制設計することが重要です。

特に厳格な現場では、“回答と一緒に参照元(文書名・章・更新日)を出す”だけで監査性と納得感が上がります。

実務的には、次の3点が鍵です。

①入力データの分類

機密・社外秘・公開情報など、データ区分を定義し、AIに投入できる範囲を明確にします。

②プロンプトと出力の監査性

誰がいつ何を入力し、何が出力され、どう判断したかを追える形にします。

③検証の仕組み

生成結果をそのまま採用せず、テスト・静的解析・レビューを通すフローに組み込みます。

厳格な現場では「AIを導入する」より「AIを運用する」能力がより重要になります。

両者に共通する生成AIの開発現場活用術

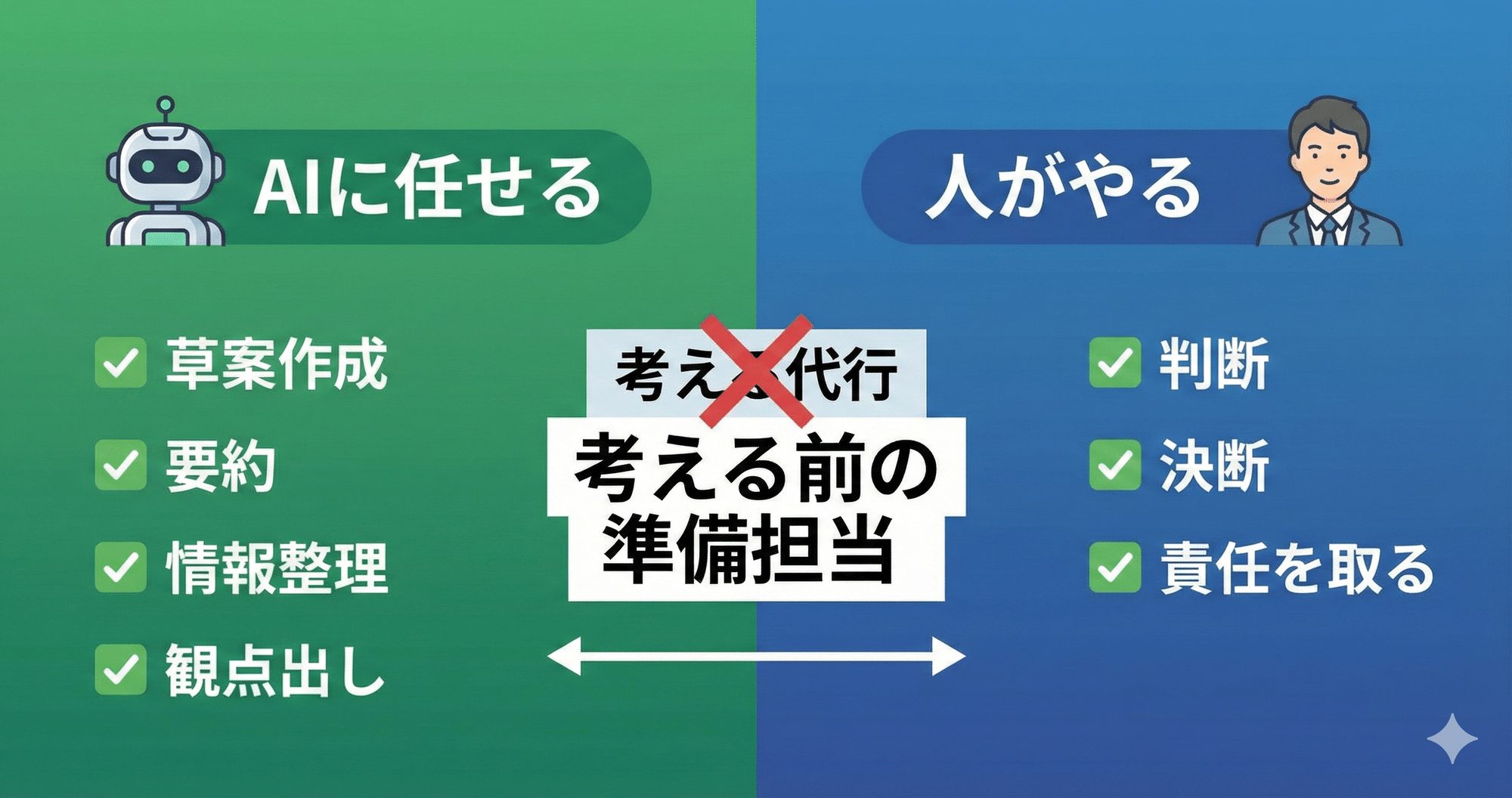

寛容な現場でも厳格な現場でも、結局は「人間の判断」をどう守るかが重要です。

おすすめは、導入前に以下を決めることです。

- AIに任せる作業

例)テスト雛形、コメント、変換作業、調査のたたき台 - 人が必ず判断する作業

例)要件の解釈、セキュリティ、設計方針、最終承認 - 禁止事項

例)顧客情報の貼り付け、認証情報や秘密鍵の入力 - 成果指標

例)レビュー時間、テストカバレッジ、障害件数、開発リードタイム

最後に

生成AI活用は“ツール導入”ではなく“開発プロセス改善”です。

寛容な現場ではスピードを、厳格な現場では統制の中での再現性を磨けます。

どちらの環境でも通用するのは、AIの出力を鵜呑みにせず、検証と責任の構造を作れるエンジニアリングです。

生成AIを味方にしつつ、品質と安全を守れるチームこそが、次の開発標準を作っていくと私は考えています。

参考文献

- MITRE/MITRE ATLAS™(Adversarial Threat Landscape for Artificial-Intelligence Systems)

- 米国国立標準技術研究所(NIST)/AI リスクマネジメント フレームワーク(AI RMF 1.0)(NIST AI 100-1)日本語訳

- OpenAI/Enterprise privacy at OpenAI

- Microsoft Learn(Microsoft)/Data, privacy, and security for Azure Direct Models in Microsoft Foundry

- DX GO(USK Net, Inc.)/ローカルLLM(Local LLM)とは?機能・仕組み・導入のポイント